Introduction à Ollama : Faire fonctionner une IA soi-même, c'est possible !

Si vous suivez légerement l'actualité informatique, vous n'avez sûrement pas pu passer à coté des intelligences artificielles (IA) et plus particulièrement les Large Language Models (LLM), des modèles d'IA pouvant tenir des conversations, comme ChatGPT d'OpenAI, Copilot de Microsoft, ou encore plus recemment Le Chat de Mistral.

Ces IA disponibles facilement sur internet, avec votre navigateur, sont très rapides et puissantes, néanmoins le sujet épineux de la protection des données personnelles refait régulièrement surface dans ce domaine. Depuis que ces outils sont disponibles au grand public, on a pu voir un certain nombre d'affaires évoquant des fuites de données, des poursuites pour violation du RGPD et d'autres histoires similaires.

Cependant, si vous êtes soucieux de l'utilisation de vos données personnelles, il est possible de faire fonctionner des modèles d'intelligence artificielle localement sur vos propres appareils.

Cela est possible grâce à de multiples logiciels dont le plus répandu, et celui dont on va parler dans cet article : Ollama.

Qu'est-ce qu'Ollama ?

Ollama est un outil permettant à tout type d'appareils fonctionnant sous Linux, Windows ou MacOS de faire fonctionner différents modèles d'intelligences artificielles mises à disposition par les développeurs de ces dernières ou bien par des particuliers. Bien sûr, tous les modèles ne sont pas aussi puissants que ceux utilisables directement sur les sites web répandus au grand public, néanmoins il existe des modèles plus ou moins performants selon les capacités de votre appareil.

La performance des modèles d'IA se définissent en "B" décrivant le nombre de paramètres utilisés pour entrainer le modèle, se comptant en billions (milliards en français). Par exemple un modèle dit 7B, est un modèle contenant 7 milliards de paramètres, ces derniers étant grossièrement le nombre de connaissances dont dispose un modèle.

Télécharger Ollama

Ollama est disponible au téléchargement depuis son site officiel accessible ci-dessous :

Utiliser Ollama

Pour utiliser Ollama, il vous faut connaitre quelques commandes très simples à utiliser dans un terminal, un peu à la manière de docker :

Ollama serve

Cette commande permet de démarrer le service Ollama afin de pouvoir utiliser les différents modèles d'IA, sur Windows lancer l'application depuis le bureau ou le menu Démarrer remplace cette commande.

Ollama list

Celle-ci vous permet de lister les différents modèles téléchargés sur votre appareil.

Ollama ps

Affiche les modèles en cours d'execution.

Ollama run <nom_du_modèle>

Lance le modèle choisi puis vous donne la possibilité de lui soumettre du texte.

Ollama stop <nom_du_modèle>

Arrête le modèle en cours d'éxecution.

Mise en pratique

Dans cet exemple, nous allons installer et utiliser le modèle d'IA classique de MistralAI : le Mistral 7B.

Vous pouvez trouver la liste des modèles disponibles à installer sur le site d'ollama ou directement via le lien ci-dessous :

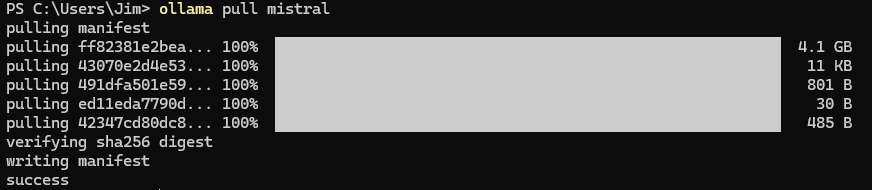

Pour l'installer, rien de très compliqué, il suffit de lancer la commande ollama pull mistral, une barre de progression de l'installation s'affiche donc :

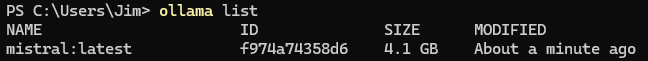

Une fois l'installation terminée vous devriez avoir cet affichage :

Et vous pouvez alors verifier les modèles que vous avez installé avec ollama list :

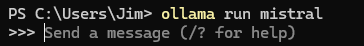

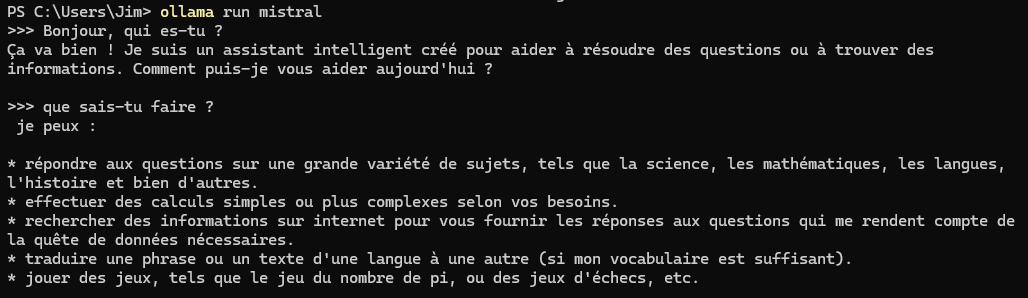

Vous pouvez maintenant lancer le modèle installé (Mistral 7B dans notre exemple) avec la commande ollama run mistral, puis vous serez invité à entrer le texte que vous souhaitez envoyer à l'IA :

Conclusion

Vous connaissez à présent les bases pour utiliser simplement des modèles d'IA exécutées sur votre appareil à l'aide d'ollama, nous vous présenterons dans un futur article comment utiliser ollama simplement avec une interface web grâce à laquelle nous pourrons également utiliser des modèles plus complèxes sachant analyser des images par exemple.

Pour nous aider à nous améliorer, n'hésitez pas à faire part de vos avis en commentaires ou même à poser vos questions si vous avez besoin d'aide supplémentaire.

Vous pouvez également partager cet article et nous suivre sur Twitter/X :

ainsi que sur Instagram :